GitHub 开发者 Lvmin Zhang 与斯坦福大学教授 Maneesh Agrawala 联合发布了一项颠覆性的AI视频生成技术— FramePack。该技术通过引入固定长度的时域上下文(Temporal Context),大幅降低显存与算力需求,使得普通硬件也能胜任高质量视频的生成任务。

在实测中,研究人员使用基于 FramePack 的 130 亿参数模型,仅借助一块 6GB 显存的显卡,就成功生成了时长达 60 秒的视频,性能表现令人惊艳。

FramePack 核心优势:

固定时域上下文:不同于传统视频扩散模型随着帧数增加而显存需求暴涨,FramePack 会自动分析输入帧的重要性,进行压缩处理,将输入统一转换为固定长度的上下文,有效控制资源占用。

显存占用低:计算量与图像扩散模型相当,大幅减少硬件门槛。

实时预览支持:每一帧生成后可立即显示,便于随时调整。

解决漂移问题:有效缓解视频长度增加后画面质量下降的“drifting”问题,实现更长、更稳、更清晰的本地视频生成。

技术架构与兼容性:

FramePack 本质上是一种多级优化的神经网络架构,目前底层采用的是定制化的腾讯混元模型。但更关键的是,它对市面上已有的预训练扩散模型也具备良好的兼容性与适配能力,便于进行迁移学习与个性化微调。

硬件与系统支持:

显卡要求:支持 FP16、BF16 精度,兼容 RTX 30、40、50 系列显卡(除 RTX 3050 4GB 外基本全覆盖)。RTX 20 系列及更早版本尚未验证,暂不支持 AMD 或 Intel GPU。

系统支持:兼容 Windows 与 Linux 系统,部署灵活。

性能表现:在 RTX 4090 上经 Teacache 优化后,生成速度可达每秒 0.6 帧,效率不俗。

一、部署要求

1、nVidia RTX 30xx、40xx、50xx 系列支持 fp16 和 bf16。GTX Titan X(Pascal)经博主测试不支持,其他 GTX 10xx/20xx 显卡未经测试。

2、Linux 或 Windows 操作系统,博主采用的是 Windows 10 IoT Enterprise LTSC。

3、6GB 显存,博主采用的是 nVidia RTX 3060Ti-8GB 显卡。

4、CUDA v12.6

5、Python 3.10.0

二、安装部署

1、下载一键安装部署包,解压缩至要运行的磁盘。博主已提前安装好 CUDA v12.6 和 Python 3.10.0。

2、科学上网

3、以管理员模式打开 CMD,运行 update.bat 进行更新

4、再运行 run.bat,运行后模型将自动下载。将从 HuggingFace 下载超过 30GB 的数据。

5、运行后,将自动打开默认浏览器,默认地址为:127.0.0.1:7860

注意:如果需要在内网的其他电脑上打开,需要修改 run.bat 文件中的 IP地址,改为:

"%DIR%\python\python.exe" demo_gradio.py --server 0.0.0.0 --inbrowser

三、生成效果

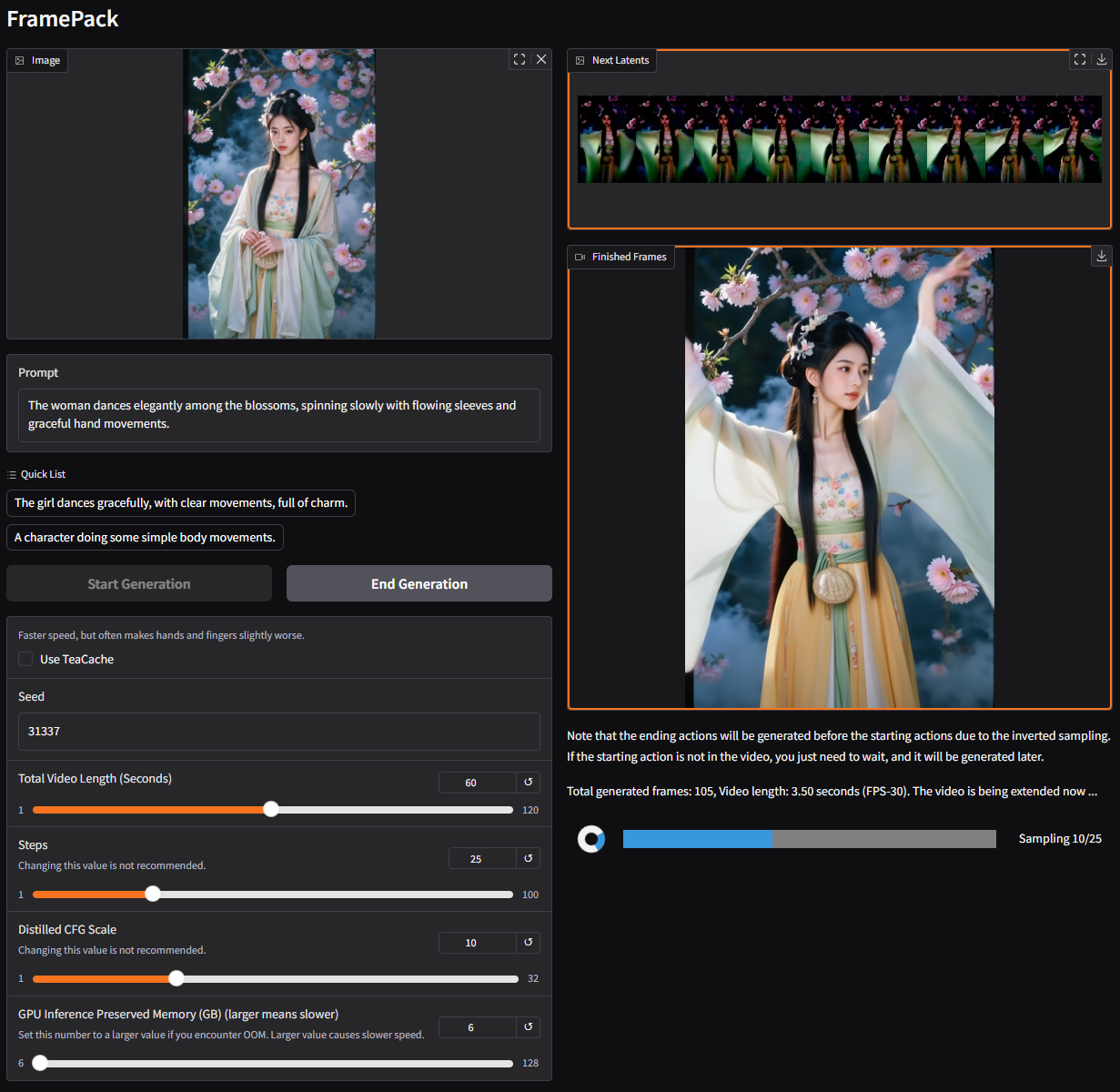

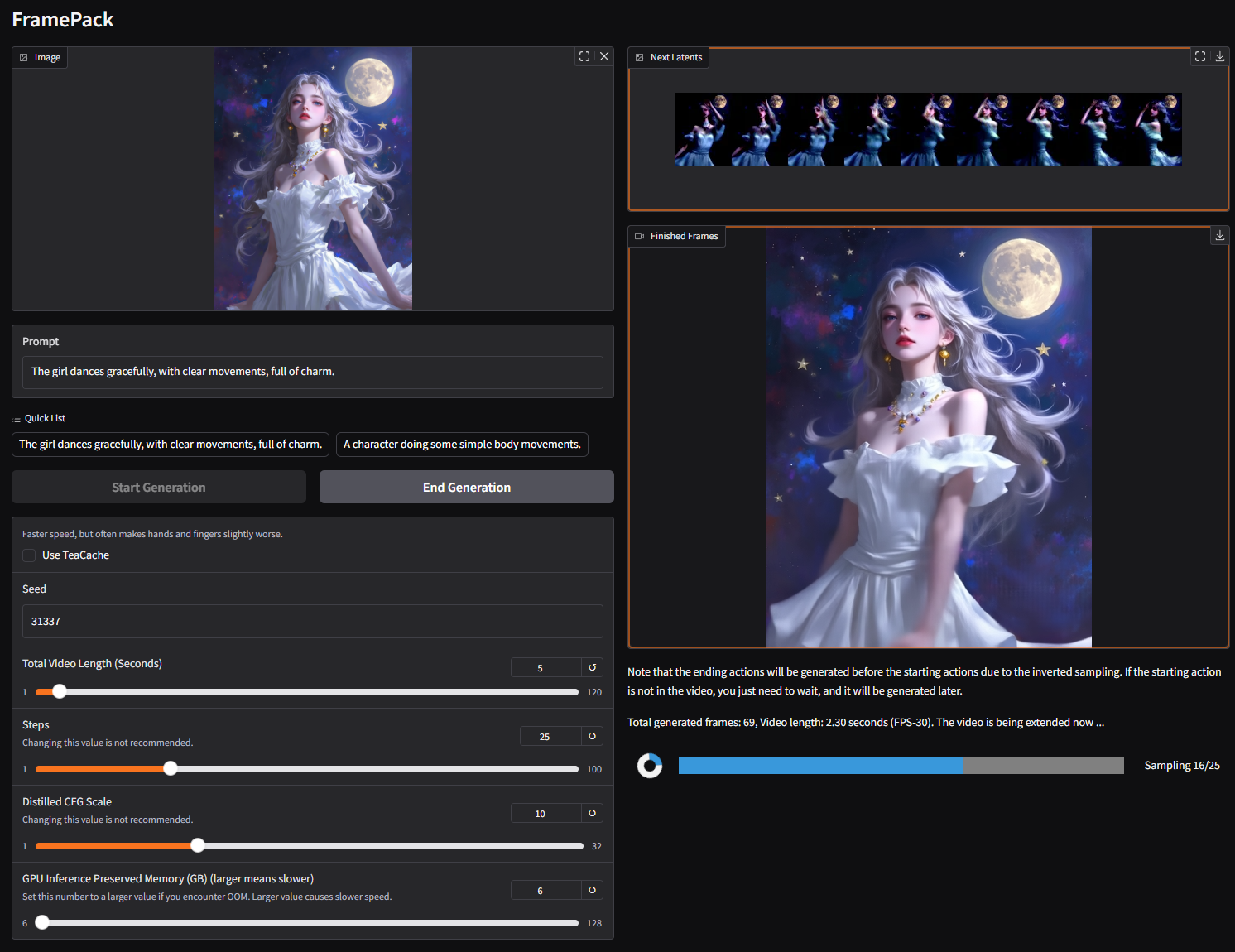

博主未对默认参数进行大的调整(未勾选【Use TeaCache】,显存设置 8GB,Total Video Length 为10 秒,MP4 Compression 为 8,Prompt 直接选择的是 Quick List 中的“The girl dances gracefully, with clear movements, full of charm.”),生成效果如下:

、

、

注意:Prompt 尽可能使用英文,其对生成的视频动作起到关键性作用。